martes, 22 de diciembre de 2009

Flare

El flare son simplemente luces parásitas que aparecen en la fotografía y que pueden degradar una imagen de forma irreversible. En algunas ocasiones puede forzarse su aparición por motivos creativos.

Aunque puede manifestarse de varias formas, las más comunes pueden observarse en la fotografía que encabeza este artículo y que ha sido realizada en el río Cabriel a su paso por la localidad valenciana de Casas del Río. Por un lado tenemos discos más menos poligonales o redondos -en realidad ésto depende del diafragma, sobre todo del número y forma de sus laminillas- y por el otro bandas luminosas de menor o mayor extensión que atraviesan la escena.

2) ¿Cómo se produce el flare?

El flare es debido a una fuente de luz de suficiente intensidad pero que queda fuera del ángulo de visión del objetivo (más sobre este tema en un artículo posterior), o lo que es lo mismo fuera del encuadre. En los casos más habituales suele ser el sol. Es decir que una fuente de luz que no aparece directamente en la imagen causa estas iluminaciones parásitas. El mecanismo del que se vale es el de las reflexiones internas en los diferentes elementos internos del objetivo. Para evitar esta circunstancia la mayoría incorporan recubrimientos antiflectantes. De hecho cuanto más compleja sea la construcción interna del objetivo más oportunidades puede haber para que el flare se produzca. Por ese motivo los objetivos zoom son más propensos a la aparición de este fenómeno que las lentes de longitud focal fija.

3) ¿Cómo podemos evitar el flare?

Una primera medida es utilizar siempre parasoles cuando tomemos fotografías en las que exista una luz intensa fuera de encuadre. Pero ésto puede no bastar. Por ejemplo, en la fotografía que acompaña al artículo se utilizó parasol.

Otra medida, ésta más efectiva, es realizar la composición del encuadre de tal manera que esa fuente intensa esté lo más alejada posible.

miércoles, 16 de diciembre de 2009

Posición del plano imagen y aumento lateral

1 1 1

(1) Ecuación de Gauss ---- + ---- = -----

s s’ f’

s’

(2) Aumento lateral m = -----

s

donde f’ es el punto focal imagen. Recordemos que la distancia entre el centro óptico de la lente y f’ se denomina “longitud focal” del objetivo.

Pero, en realidad ¿para qué sirven?

La respuesta es que la ecuación (1) nos da la posición del plano imagen para un plano de enfoque dado. La ecuación (2) nos da el tamaño relativo de la imagen de un sujeto en relación al tamaño real del sujeto mismo.

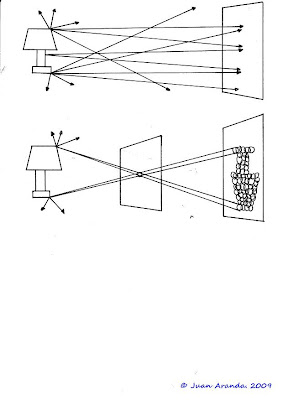

Gráficamente podemos observar las consecuencias de estas fórmulas en el diagrama que acompaña al artículo.

Veamos qué nos dicen las fórmulas.

En éstas , infinito (∞)significa una distancia lo suficientemente grande como para que los rayos que provienen de la escena viajen casi paralelos. En la práctica 100 metros puede ser infinito.

Posición del plano imagen en relación al plano de enfoque

1 1 1

a) Si s = ∞, entonces por (1) ---- + ----- = ----

∞ s’ f’

1 1

Como 1/0 vale ∞ tenemos ----- = ------ o bien s’ = f’

s’ f’

Es decir, los rayos que provienen de planos de enfoque muy alejados forman su imagen en el punto focal imagen F’.

1 1 1

b) Si s = 2f’, entonces por (1) ----- + ----- = ------

2f’ s’ f’

1 1 1 1

O sea ---- = ---- - ----- = ------ o bien s’ = 2f'

s’ f’ 2f’ 2f’

Es decir, que si el plano de enfoque está a 2 veces la longitud focal , el plano imagen se sitúa también a 2 veces la longitud focal.

OBSERVACION 1: De esto se deduce que cuando el plano de enfoque se encuentra entre infinito (∞) y 2 veces la longitud focal, el plano imagen se encuentra a una distancia entre 1 y 2 longitudes focales.

1 1 1

c) Si s = f’, entonces por (1) ---- + ----- = -----

f’ s’ f’

1

O sea ------ = 0 o bien s’ = ∞

s’

Es decir, que si el plano de enfoque se encuentra a una distancia de 1 longitud focal, el plano imagen se encuentra en infinito (∞). O lo que es lo mismo, no se forma imagen.

OBSERVACION 2: De esto se deduce que cuando el plano de enfoque se encuentra entre 2 y 1 veces la longitud focal, el plano imagen se encuentra a una distancia entre 2 veces la longitud focal e infinito (∞).

En la práctica es muy (pero que muy) poco habitual que un objetivo pueda enfocar a algo tan cercano como 2 longitudes focales. Por tanto la OBSERVACION 1 es la única que nos interesa en fotografía.

Aumento lateral del tamaño de la imagen con respecto al tamaño del sujeto

a) Si el plano de enfoque se encuentra entre ∞ y 2 veces la longitud focal se verifica que:

2f’ < s < ∞ y por lo visto anteriormente f’ < s’ < 2f’

Por tanto s’ < s y el aumento lateral m es menor que la unidad, lo cual significa que la imagen del sujeto es menor que el sujeto mismo. Esto es lo habitual en fotografía.

b) Si el plano de enfoque se encuentra a 2 veces la longitud focal se verifica que:

s = 2f’ y por lo visto anteriormente s’ = 2f’

Por tanto el aumento lateral m es igual a la unidad.

c) Si el plano de enfoque se encuentra entre 2 y 1 veces la longitud focal se verifica que:

f’ < s < 2f’ y por lo visto anteriormente 2f’ < s’ < ∞

Por tanto s < s’ y el aumento lateral m es mayor que el sujeto mismo.

Querría aclarar inmediatamente que estas consideraciones no tienen ninguna relación con lo que se conoce como fotografía de aproximación o fotomacrografía, que se rige por otros parámetros muy distintos.

martes, 8 de diciembre de 2009

Trípodes

a) Bajas velocidades de obturación

Cuando deseamos realizar una fotografía y bien por las condiciones de luminosidad (baja) o por emplear un filtro de densidad neutra, la velocidad de obturación sea sensiblemente menor que (1/longitud focal) es impensable que pretendamos conseguir una nitidez aceptable sujetando la cámara a pulso. Si así lo hacemos, inevitablemente, quedará movida, borrosa, etc y por tanto inutilizable. (una excepción será el hecho de que por motivos creativos, sea ésto precisamente lo que queramos).

b) Largas longitudes focales

Relacionado con el punto anterior, cuando usamos un teleobjetivo de longitud focal larga (en la práctica por encima de los 200 mm) habrá pocas condiciones luminosas que nos permitan conseguir fotografías nítidas, dado que en la mayoría de los casos necesitaremos velocidades de obturación muy altas. En este escenario, el uso del trípode se hace prácticamente inevitable.

c) Fotografías HDR

Aquí el problema no viene inducido por la necesidad de utilizar bajas velocidades de obturación en relación a la longitud focal empleada. El problema es que las diferentes fotografías que se utilizan (cada una con diferente valor de exposición) deben estar perfectamente alineadas para que el software HDR sea capaz de integrarlas en una única sin producir ningún tipo de imperfección o halo. Cabe señalar que en este caso si en el encuadre de la toma hay elementos móviles (por ejemplo, árboles movidos por el viento), el trípode no supondrá ningún tipo de ayuda.

d) Fotografía de aproximación

En esta rama de la fotografía en la cual la imagen del sujeto tien una fracción significativa del tamaño del sujeto mismo (En el caso más extemo son iguales) el problema surge desde un ámbito diferente. Aquí lo que pasa es que la profundidad de campo suele ser tan pequeña que si utilizáramos la cámara a pulso, correríamos el riesgo de que la parte nítida de la fotografía no se correpondiera con la zona deseada. Para asegurar que sea la correcta, el uso del trípode vuelve a ser absolutamente imprescindible.

Desde el punto de vista de su utilización práctica, la primera cuestión a considerar es la existencia de dos tipos bien diferenciados , los que podríamos llamar normales y los de mesa, mucho más pequeños y en muchos casos incapaces de soportar una cámara réflex digital de tamaño (y peso) grande. Cabe señalar asimismo una fauna diversa de elementos de estabilización que va desde los monopiés, pasando por los denominados trípodes gorilla a los simples saquitos de habichuelas, que por brevedad no entraremos a comentar.

Dentro de los que he definido como trípodes normales una primera división habría que hacerla entre los integrales y los que se construyen con una combinación específica de patas y rótula (el elemento en el que va a ir anclada la cámara). Los primeros son más baratos y desde mi punto de vista no recomendables. En cuanto a los segundos, hay que hacer la salvedad de que en este caso la palabra trípode se utiliza tanto para hacer referencia a las patas mismas como al conjunto.

Las patas más caras son de fibra de carbono que es un material ligero y para un uso no profesional quizás excesivamente caras. (Depende, por supuesto, del presupuesto de cada cuál).

En cuanto a las rótulas existen dos variedades, las de bola y las de manivelas. Las primeras permiten mediante el deslizamiento de una bola en un soporte obtener todos los grados de libertad posible. El problema es que las de mayor calidad (las únicas recomendables) son bastante caras. En cuanto a las de manivelas lo más importante es que permitan los tres grados de libertad: es decir que el movimiento de la cámara se pueda hacer a lo largo, ancho y alto.

¿Qué características deseables debe tener un trípode?

Evidentemente la respuesta va a depender de las necesidades específicas de cada fotógrafo en particular. Lo único que puedo hacer es dar mi opinión al respecto.

Estas características son:

a) Es absolutamente imprescindible que la rótula tenga una tapilla desmontable para ajustar a la cámara y posteriormente ambas, de forma solidaria, anclarlas a la rótula. Si un trípode no dispone de este elemento, huir. En la práctica todos los trípodes de cierta calidad disponen de ello.

b) Es muy interesante que la rótula disponga de una escala graduada al menos en el plano paralelo al suelo. De esta manera nos resultará muy útil para realizar panorámicas. La necesidad surge del hecho de que el software que integra la panorámica necesita un cierto grado de solapamiento entre las diversas tomas para hacer correctamente su trabajo. Este elemeto nos será de enorme utilidad.

d) Sería conveniente que el pilar central del trípode pudiera colocarse en horizontal. Esta disposición será la adecuada para poder tomar fotografías de aproximación, con el objetivo apuntado hacia el suelo.

e) Un elemento menor, pero que recomiendo encarecidamente: Que alrededor de una o varias patas lleve algún tipo de acolchamiento. Esto nos permite coger el trípode con más comodidad y sobre todo evita en invierno que las manos se nos congelen en contacto con el metal.

f) Un último elemento que quiero comentar es la presencia de un nivel para conseguir la perfecta horizontalidad. Sé que muchos fotográfos lo consideran un elemento importante, pero yo personalmente no le he encontrado nunca ninguna utilidad. Pero como no me cansaré de recordar, mi posición es simplemente la de fotógrafo aficionado.

viernes, 4 de diciembre de 2009

Ecuación de Gauss

Observemos la la imagen que acompaña al artículo.

En los triángulos semejantes ABO y A'B'O se verifica que:

A'B' OB' s'

--- = --- = ---

AB OB s

En los triángulos semejantes OPF' y F'A'B' se verifica que:

A'B' F'B' s' - f'

--- = --- = -------

OP OF' f'

Teniendo en cuenta que AB es igual a OP, podemos decir que

s' s' - f'

--- = ------

s f'

o bien:

s' s' f'

--- = --- - ---

s f' f'

Si dividimos ambos miembros por s' nos queda:

1 1 1

--- = --- - ---

s f' s'

lo cual puede ser expresado como:

1 1 1

--- + --- = ---

s s' f'

que es la Ecuación de Gauss.

Aumento lateral

El aumento lateral de una lente m es el cociente entre la altura de la imagen y la altura del sujeto.

En la figura adjunta si prescindimos de signos (trabajamos únicamente con valores absolutos) tendremos

que:

y'

m = --- ( por definición)

y

Si nos fijarmos en los triángulos semejantes APO y OB'A' nos encontramos que se verifica que las

tangentes de los ángulos son iguales y por tanto :

y' y

--- = ---

s' s

de donde :

s'

m = ---

s

que es la fórmula del Aumento lateral.

jueves, 26 de noviembre de 2009

Resolución de impresoras: ¿Pixeles por pulgada o puntos por pulgada?

Primero:

La resolución de una imagen es el número de pixeles que contiene. Punto.

Y el concepto de pixel es puramente abstracto.

Pero .....

Cuando esa imagen debe plasmarse en el mundo real, debe ser dispuesta en una superificie y dependiendo del dispositivo, utilizar una u otra tecnología para dar soporte a cada pixel. Aquí es donde empiezan los problemas.

Segundo: Sensores de cámaras fotográficas

La resolución en los sensores se da simplemente como número de pixeles. Sin más. ¿Es que aquí no existe el concepto de pixeles por pulgada?. Por supuesto, no es lo mismo incluir 10 millones de pixeles en el sensor de una pequeña compacta que en el de una réflex digital de formato completo.

Pero, en este ámbito, la densidad de pixeles por pulgada no se toma en consideración.

Tercero: Monitores de tubos de rayos catódicos

Aquí la resolución siempre se ofreció como una densidad de pixeles por pulgada. Quiero hacer notar que ésta es una densidad lineal. Y las densidades reales son por superficie. La suposición no expresada explícitamente es que esa densidad lineal era la misma tanto a lo ancho como a lo largo. Esta situación se mantiene hasta la actualidad.

¿Por qué aquí la resolución se define como una densidad?

La respuesta es que en estos dispositivos, la pantalla no tenía resolución. Simplificando mucho podemos decir que el interior de la pantalla estaba recubierto de una sustancia fosforescente que brillaba cuando impactaba sobre ella un chorro de electrones. En realidad en este caso la resolución la dictaba únicamente la tarjeta gráfica. Así, modificando los parámetros de la tarjeta gráfica, podíamos obtener resoluciones (densidades) distintas utilizando el mismo monitor.

Cuarto: Monitores TFT

Aquí la resolución se vuelve a dar en número de pixeles. ¿Por qué?

Por que estos monitores tienen una resolución nativa y tienen un patrón de elementos capaz cada uno de visualizar un pixel. Por tanto aquí intervienen tanto la tarjeta gráfica como el propio monitor con las siguientes consideraciones. Aunque activemos la tajeta gráfica en un modo de mayor resolución que la disponible en el monitor no conseguiremos nada. Sólo se podrán ver los pixeles que tiene el monitor. Si la resolución es menor despreciaríamos pixeles de éste. Por tanto, en la práctica, el modo de resolución de la tarjeta gráfica se hace coincidir con la resolución nativa del monitor.

¿Es que aquí no hay densidad de pixeles?. Por supuesto, si queremos cambiar la densidad sólo tendremos que ...........

utilizar un monitor distinto de diferente número de pulgadas. En este ámbito, obviamente nadie habla de densidades.

Quinto: Impresoras

Aquí sí que se habla de densidades. El problema es que se habla de dos densidades distintas. ¿Cuál es la correcta: pixeles por pulgada o puntos porpulgada?

Y la respuesta es ..........

AMBAS.

En realidad son dos densidades distintas. Los pixeles por pulgada indican lo que su nombre indica y los puntos por pulgada indican cuántas gotitas de tinta es capaz de colocar la impresora en una pulgada (Recordemos que la densidad es, en realidad superficial y se mantiene lo dicho más arriba).

En realidad podemos manipular estos dos parámetros de forma completamente independiente.

Para entenderlo mejor utilicemos un ejemplo.

Una imagen decidimos imprimirla con 144 pixeles por pulgada. Y esta densidad la elegimos por software.

Esa misma imagen decidimos imprimirla con 1440 puntos por pulgada. Y esta densidad la elegimos, independientemente de la anterior, también por software.

Esto significa que hay 10 puntos lineales por pixel. O lo que lo mismo 100 = 10 x 10 puntos por pixel.

Si hacemos otra elección diferente, por ejemplo 288 pixeles por pulgada y 2880 puntos por pulgada seguimos teniendo 10 puntos lineales por pixel. Y al igual que antes 100 = 10 x 10 puntos por pixel. Lo único que cambia es que ahora ese pixel en el papel se representa en una superficie que es una cuarta parte de la anterior.

Evidentemente la elección de los números no es inocente, porque coincide con las densidades de puntos habituales en la impresoras de inyección de tinta.

Eso es todo, amigos.

viernes, 20 de noviembre de 2009

Lentes Delgadas

partida por la mitad, posteriormente exprimida y los dos casquetes resultantes vueltos a unir. Aunque ésto no sería una lente delgada porque su "espesor" sería el diámetro de la naranja. Una imagen esquemática puede observarse en la figura que acompaña al artículo.

Dos definiciones:

a) Eje de la lente (o eje óptico) es una línea imaginaria que conecta los centros de las dos esferas. (Línea que une C1 y C2 en la figura).

b) Centro óptico es el centro geométrico de la lente. Se encuentra sobre el eje óptico (O en la figura).

Una lente delgada (convergente) se representa de forma simplificada tal como aparece en la figura inferior. Alguna definición más:

c) La longitud focal de una lente delgada puede definirse como:

c.1) La distancia entre un punto denominado Foco objeto y el centro óptico, cuya imagen se encuentra en el infinito. (F1 en la figura)

c.2) La distancia entre un punto denominado Foco imagen y el centro óptico, que es le imagen de un punto situado en el infinito en la escena. (F2 en la figura)

Si las dos esferas son exactamente del mismo radio, esta definición es consistente.

Dadas estas condiciones, en una lente delgada se verifican las siguientes circunstancias:

1) Todo rayo paralelo al eje óptico que proviene de la escena, pasa por el foco imagen.

2) Todo rayo que pasa por el foco objeto emerge paralelo al eje óptico.

Es posible utilizar esta información para obtener la imagen de una objeto, PQ en la figura, por métodos puramente gráficos. Así podemos observar en la figura que el rayo que sale de P paralelo al eje óptico, acaba pasando por F2. De igual manere, el rayo que emerge de P y pasa por F1, sale paralelo al eje óptico. Con dos rayos únicamente ya es posible ver cuál será el punto en que intersecten y ahí estará la imagen de P, P'. Dado que cada plano de la escena se convierte en un plano en la imagen, es fácil determinar donde se encuentra la imagen de Q, q'. La imagen completa se ha obtenido.

Esta simplificación de la realidad nos va a servir, en posteriores artículos, para poder determinar dónde se forma la imagen de un objeto de la escena real, cómo varía la profundidad de campo y foco con la variación de la longitud focal y otra serie de cuestiones que serán posteriormente abordadas.

viernes, 13 de noviembre de 2009

Flash de relleno

Cuando hablamos de flash de relleno, técnicamente estamos hablando (habitualmente) de flash de sincronización lenta, pero hay un matiz. Cuando el fondo es más oscuro que el sujeto de primer plano, se utiliza la terminología de flash de sincronización lenta porque las velocidades de obturación son lentas. Cuando el fondo es más luminoso que el sujeto de primer plano, hablamos de flash de relleno. En este caso las velocidades de obturación son más rápidas. En cualquier caso siempre existe el límite superior de la velocidad de sincronización. Por ejemplo, en la Nikon D200, esta velocidad es de 1/250 seg.

Resumiendo: Flash de relleno es la situación en que intentamos exponer adecuadamente tanto el sujeto en primer plano como el fondo, pero con la particularidad de que el fondo es más luminoso que el sujeto en primer plano. En esas circunstancias las velocidades de obturación serán relativamente rápidas.

Existe un problema adicional que se relaciona con lo que habitualmente necesitamos cuando usamos flash de relleno, en contraposición a lo que necesitamos cuando utilizamos estrictamente flash de sincronización lenta. Me explico:

Si utilizamos flash de sincronización lenta, el fondo será oscuro y nuestra intención es que se vea correctamente expuesto y además que se vea con nitidez. Es decir, que la apertura de diafragma será relativamente pequeña (números f grandes). Esto ocurrirá en situaciones de baja iluminación, típicamente por la noche en exteriores. Si utilizamos flash de relleno, desearemos que el fondo quede adecuamente expuesto, pero también, en la mayoría de las ocasiones, desenfocado. En ese caso utilizaremos aperturas de diafragma grandes (números f pequeños).

Esto marca una diferencia, no debida en realidad directamente al flash, entre lo que estrictamente se denomina flash de sincronización lenta y flash de relleno. Será la velocidad de obturación que decidamos utilizar, la que realmente marcará que usemos flash de sincronización lenta o flash de relleno. Y esta decisión vendrá determinada, en realidad, por la luminosidad relativa del fondo con respeto al sujeto principal.

Un último apunte. No debemos esperar encontrar en nuestra cámara ( o flash, si es externo) necesariamente unos modos de operación marcados de esta manera. Por ejemplo, en el caso de la Nikon D200 podemos conseguir flash de relleno de tres formas distintas: Una es utilizar la modalidad de flash de sincronización lenta , la segunda es una modalidad específica de los flashes de Nikon y la tercera es el modo de sincronización automática, por defecto del flash.

domingo, 8 de noviembre de 2009

Profundidad de campo y profundidad de foco

El objetivo de una cámara fotográfica está formado por varias lentes pero, para la explicación que sigue en este artículo y en los siguientes, es más conveniente considerar que utilizamos una única lente convergente equivalente al conjunto. Esta lente presenta un plano de simetría perpendicular al eje óptico (una línea imaginaria que desde la escena, atraviesa el objetivo, posteriormente el sensor, y luego continúa indefinidamente). Le llamaremos el plano del objetivo.

Todos los puntos de cada plano de una escena convergen en puntos que se encuentran contenidos en su correspondiente plano imagen. Cuando utilizamos el anillo de enfoque, lo que estamos haciendo es variar la distancia entre el plano en el que se encuentra el sensor (el denominado plano focal) y el plano del objetivo.

(NOTA: El plano focal está situado sobre la longitud focal, únicamente cuando enfocamos a infinito).

Esto conduce a seleccionar uno de los planos de la escena de tal manera que su plano imagen se constituya en el plano focal . A este plano lo denominaremos plano de enfoque.

La profundidad de campo es el conjunto de planos anteriores y posteriores al plano de enfoque que forman en el plano focal círculos imágenes inferiores en tamaño al círculo de confusión. Debido a la limitación en la visión humana, los observamos en la imagen como perfectamente nítidos, aún cuando en realidad, perfectamente nítido, sólo hay uno: el plano de enfoque. Por tanto, y esto es importante, la profundidad de campo hace referencia a los planos de la escena, en concreto a aquellos que apreciamos con nitidez.

La profundidad de foco mide la mayor o menor dificultad para realizar el enfoque. Para poder entender el concepto debemos recurrir a un experimento imaginario, tal como se observa en la figura que acompaña al artículo. Si movemos (hacia adelante o hacia atrás) el plano focal, manteniendo constante el plano de enfoque, observamos que el punto imagen se convierte en un círculo. Cuando sobrepasemos el tamaño del círculo de confusión empezaremos a

ver la imagen borrosa. Si hay poca profundidad de foco, significa que rápidamente empezaremos a ver borroso, por tanto nos será más sencillo enfocar. Si la profundidad de foco es mayor, tardaremos más en observar el desenfoque y nos costará más enfocar. Es decir que, en este caso, cuanto peor, mejor. Por tanto la profundidad de foco hace referencia al desplazamiento del plano focal necesario para que podamos apreciar la falta de nitidez.

Es muy importante comprender que lo anterior es un experimento imaginario. Si cambiamos realmente la distancia entre el plano focal y el plano del objetivo utilizando el anillo de enfoque, lo que conseguiremos será obtener una plano de enfoque distinto. Y en la premisa de nuestro experimento se consideraba que el plano de enfoque permanecía constante.

lunes, 2 de noviembre de 2009

Perfiles de color

Existe el concepto de Corrección del Color. Este es un tema en realidad subjetivo. Una fotografía de una puesta de sol puede tener una tonalidad anaranjada que una persona puede percibir como excesiva y a otra le enamore. La primera tratará de eliminarla con las herramientas a su disposición. La segunda la mantendrá: Para una, la tonalidad será correcta y para la otra no. Aquí no intervienen para nada los perfiles de color.

Cuestión diferente es el tema de la Administración del Color. Esta trata de que los colores que se observan en el monitor sean "exactamente" los mismos que se obtendrán en la copia impresa (en realidad, exactamente del todo, es imposible, pues una tecnología es emitiva y la otra reflexiva). Se pueden utilizar también perfiles de otros dispositivos, tales como los Escanneres.

Aquí entran de lleno los perfiles de color, conocidos como perfiles ICC debido a la institución en la que fueron desarrollados. Estos perfiles son unos ficheros informáticos, independientes de Sistema Operativo, que contienen unas tablas de conversión en dos sentidos. Y trabajan con espacios de color RGB. Convierten los números del espacio de color de ese dispositivo concreto en una representación en el espacio (y modelo) de color Lab. Y viceversa. El espacio (y modelo) de color Lab funciona pues como un mecanismo de traducción intermedia entre dispositivos.

En realidad la cuestión anterior debe ser matizada en dos aspectos.

a) Existen perfiles de color genéricos para una modelo de dispositivo, por ejemplo todas las impresoras Epson R800 con papel premium glossy, aunque una unidad particular puede mostrar ligeras diferencias con este perfil. En la práctica la mayoría de los fotógrafos aficionados usamos estos perfiles genéricos.

b) También se contempla la traducción con espacios de color no ligados a un dispositivo. Cuando una fotografía es abierta en un editor gráfico, su representación se hace en el espacio de color Adobe RGB, sRGB u otros. Es necesario un perfil que realice una adecuada representación en el monitor que estamos utilizando.

En relación con la corrección del color, una adecuada administración del color, hará que una fotografía con una tonalidad magenta en el monitor se imprima con ese mismo tono magenta en la impresora.

Un aspecto diferente hace referencia a la calibración de un dispositivo. En este caso nos estamos refiriendo al hecho de que el espacio de color de ese dispositivo puede cambiar con el tiempo. El caso más obvio es el de los monitores. Si usamos un colorímetro y el software adecuado, podemos generar un perfil exacto del dispositivo concreto. Si la representación de colores de ese dispositivo cambia con el tiempo -es decir, cambia su espacio de color- es necesario calibrar el dispositivo para obtener un perfil que sea adecuado a las nuevas circunstancias.

martes, 27 de octubre de 2009

Círculo de confusión

sábado, 17 de octubre de 2009

Límites en la manipulación de fotografías digitales

a) El movimiento de los ojos a diferentes partes de la escena produce el efecto de conseguir enfoques a diferentes distancias.

b) Si el ojo se mueve a una zona clara la pupila se cierra. Si se mueve a una zona oscura se abre.

c) La respuesta a la luminosidad no es lineal. Si aumenta mucho la luminosidad su percepción no aumenta en la misma medida.

Cuando una cámara fotográfica registra una escena, las cosas suceden de una forma muy distinta.

a) El punto de enfoque es único para toda la escena. Esto puede dar lugar a desenfoques selectivos.

b) La apertura del diafragma es única.

c) La respuesta a la luminosidad es lineal (en cámaras digitales).

Por tanto, si deseamos acercar el resultado de una toma a nuestra percepción humana, en el momento en que fue realizada, es necesario procesar la imagen de alguna manera. El resultado de la toma, tal como sale de la cámara, es meramente un paso intermedio. Esto es tanto más cierto, en cuanto que la toma haya producido un fichero raw, que ni siquiera es una imagen digital.

La pregunta que surge en ese momento es ¿cuáles son los límites en ese procesamiento?. La actualidad está llena de informaciones que denuncian la manipulación de imágenes mediante "photoshop".

En este asunto hay tantas respuestas posibles como personas. Aquí yo proporcionaré la mía particular.

En general creo que una manipulación fotográfica que se limite a luminosidad y color es permisible. Esto puede dar lugar a fotografías que poco tienen que ver con la realidad -HDR extremo, por ejemplo- pero la creatividad del fotógrafo, desde mi punto de vista, está por encima de la fidelidad a la realidad. Manipulaciones necesarias para evitar ruido o enfocar la escena se pueden realizar siempre, sin ningún tipo de limitaciones.

Si se trata de eliminar elementos de la escena, lo fundamental es que no sean esenciales para esa escena. El problema es que decidir qué es esencial o qué no lo es tiene una enorme carga de subjetividad. Las famosas eliminaciones de personas que, en algunas fotografías, acompañan a Stalin , según eran purgadas, es un ejemplo en el que la mayoría convendrá que se elimina un elemento esencial (La manipulación ya existía en la época de la fotografía química). Eliminar un cable de un paisaje, una persona de un monumento, etc serían, desde mi punto de vista, eliminaciones permitidas.

El asunto más polémico es el que se refiere al fotomontaje. Es decir a la construcción de imágenes que nunca han existido a partir de fragmentos de otras imágenes. En ese punto mi opinión particular es que no debe de utilizarse salvo que haya unas muy buenas razones para ello. Y entre esas razones no me vale la llamada a la creatividad. Reconozco que la creación de fotomontajes es una actividad perfectamente razonable, pero yo no la llamaría ya fotografía sino imagen digital.

¿Qué tipo de razones harían permisible el fotomontaje para que aún pudiéramos llamarlo fotografía?.Lo mejor será utilizar una ejemplo. Si utilizamos el enlace http://picasaweb.google.com/fotosdearanda2/SerieDeEdificiosHistoricos, podremos observar una fotografía sobre el Parador Nacional de Alarcón que es un fotomontaje. El problema es que a pesar de obtener cinco tomas adecuadas (histograma mediante) para HDR, el resultado del proceso mediante más de un software específico ha resultado insatisfactorio. Por algún motivo que desconozco, en este caso particular, el software HDR ha sido incapaz de procesar adecuadamente las fotografías aunque las diferentes tomas cubrían adecuadamente el rango dinámico necesario. La única solución ha consistido en utilizar el cielo de una toma y el parador de otra.

Mención aparte exigen las burdas manipulaciones realizadas en el contexto de fotografías de modelos, donde la modificación introducida es una profunda distorsión del original. Aun cuando técnicamente no es un fotomontaje, dado que no se utilizan elementos de diferentes tomas, se produce una modificación apreciable de las líneas maestras de la toma que no es una mera modificación de color y/o luminosidad. Esta actividad no es ética desde ningún punto de vista y coincido con muchas personas en que fotografías de este tipo debieran llevar anexa una etiqueta que informase de su manipulación digital extrema.

jueves, 15 de octubre de 2009

Espacios de color

jueves, 8 de octubre de 2009

Formación de imágenes utilizando un objetivo

viernes, 2 de octubre de 2009

Resolución de monitores

El problema reside en que históricamente ha habido dos significados diferentes para esta palabra. Cuando la mayoría de los monitores utilizaban latecnología de rayos catódicos, es decir la misma de la antiguas televisiones convencionales, la palabra resolución hacía referencia a una densidad de pixeles. En aquellos momentos existía una resolución máxima condicionada por las prestaciones de la tarjeta gráfica que se utilizara. En esas circunstancias, dado el tamaño máximo de las pantallas - en torno a las 15 pulgadas - lo habitual es que su utlización condujera a unas interfaces gráficas en las cuales los elementos básicos, los menús, los iconos, etc resultaran demasiado pequeños para ser visualizados confortablemente. En la práctica la mayoría de usuarios utilizaba una resolución menor de la que permitía la propia tarjeta gráfica. Y la resolución se definía como el número de pixeles por pulgada. Es decir, una densidad de pixeles.

A partir del momento en el que la tecnología de monitores evolucionó a los actuales TFT, la situación dió un giro. En primer lugar estos monitores tienen una resolución nativa dada por el número de pixeles que puden visualizar, algo que no ocurría con los basados en tubo. Por tanto nos basta con hacer coincidir la resolución que es capaz de producir la tajeta gráfica con la propia resolución nativa del monitor. Dado que estos monitores poseen unas dimensiones superiores a los CRT, la mayoría, por no hablar de la totalidad, de los usuarios trabajan habitualmente a la resolución máxima. Se da el hecho adicional de las tarjetas gráficas instaladas suelen tener como resolución máxima la correspondiente a la que considera habitual en los monitores de cada nicho de mercado.

Un hecho adicional que ha convertido la palabra resolución de un monitor en un número absoluto de pixeles y no en una densidad,tal como ocurría en la tecnología anterior, es que los televisores TFT suelen medir su resolución de esta manera desde que las estrategias de marketing han promocionado la alta definición, sobre todo en referencia a lo que se conoce como Full HD (un nombre, por cierto, controvertido), o lo que es lo mismo 1920 x 1080 pixeles.

En este contexto la relación entre la resolución de la imagen (en pixeles reales) y la del monitor quedan perfectamente aclaradas. Si observamos una imagen de (redondeando) 3000 x 2000 pixeles en un monitor de 1600 x 1200 pixeles es obvio que en cada momento sólo podremos visualizar una parte de esa imagen. Moviendo las barras de desplazamiento lateral en cualquier editor podremos, por supuesto, acceder a otras partes de la imagen.

Un asunto adicional es que habitualmente no observamos las imágenes en pixeles reales sino que se aplica un factor de reducción (sólo visualizamosuna parte de los pixeles) con el objetivo de encajar la imagen en el monitor y que pueda verse completa.

sábado, 26 de septiembre de 2009

Modelos de color

La respuesta vino del hecho de que cualquier color es reproducible mediante una adecuada combinación de rojo, verde y azul en diferentes proporciones. Son los conocidos como colores primarios "aditivos". También es posible conseguir cualquier color mediante diferentes proporciones de cyan, magenta y amarillo. Son los colores primarios "substractivos". La diferencia entre ambos es que con los primeros podemos conseguir cualquier color emitiendo luz. Por ejemplo, un monitor. Con los segundos mediante reflexión. Por ejemplo, una hoja de papel con tinta de diferentes colores.

Esta oportunidad se reflejó en el primer modelo de color desarrollado en los años 30 del siglo XX por la CIE, Comission Internationale de L'Eclaraige (Comisión Internacional de Iluminación, en castellano) que utilizó un método experimental basado en pruebas realizadas sobre voluntarios humanos que mediante el ajuste de rojo, azul y verde debían reproducir un color de muestra. Los resultados se matematizaron y se creó el modelo CIE XYZ en el cual los primarios ya no eran rojo, verde y azul sino parámetros teóricos. ¿Cómo se hizo ésto?. Ni idea. Ni siquiera en los libros sobre teoría del color lo aclaran completamente.Por tanto ¿Qué es un modelo de color?. Sencillamente un mecanismo de identificación de un color mediante tres valores primarios. ¿A qué corresponde cada uno de estos valores?. A diferentes cosas en diferentes modelos. Ya está. No hay más. Lo que es muy adecuado, por otro lado, para poder realizar una manipulación informática. Recordemos que los ordenadores, en última instancia, se limitan a manipular números.

Es el modelo de referencia, en el sentido de que describe todos los colores que el ser humano

-en realidad , el calificado como observador standard- es capaz reconocer. El resto de los modelos de color se puden entender y representar con relación a éste.Los más importantes son:

a)Lab

Este modelo de color toma como valores primarios dos colores a y b; a se encuentra entre el azul y el amarillo; b entre el rojo y el verde. L representala luminosidad. Es muy importante en las aplicaciones prácticas de la teoría del color en informática porque es el equivalente a la lengua inglesa en el contexto de las lenguas naturales. Sirve como paso intermedio de traducción en la gestión de perfiles de color. Pero ésto será explicado en otro artículo.

b)HSB

Este modelo de color toma como valores primarios el tono (hue), la luminosidad (brightness) y la saturación (Saturation). Por ejemplo, es utilizado en Photoshop para la elección de colores con el "cuentagotas".

c)RGB

Por la elección de valores primarios R(Red, rojo), G(green, verde) y B(Blue, azul). Es el principal modelo utilizado por los editores gráficos. En éste, cada canal se valora entre 0 y 255 (para imágenes de 8 bits por canal) correspondiendo el cero al tono más oscuro y el 255 al más brillante. La saturación se concreta en valores análogos para cada canal. Por ejemplo 134, 134, 134 da un tono muy poco saturado que se corresponde con un nivel de gris.

d) CMYK

Es la variante sustractiva del RGB. Cada color se identifica por sus contribuciones de cyan, magenta y amarillo. Es un caso especial con 4 valores primarios. El último K se refiere al negro (blaK). Es necesario porque en la práctica la unión de las tres tintas en su máxima saturación no es capaz de obtener el negro, sino un marrón muy oscuro. Por ese motivo es necesario en impresión utilizar una tinta negra adicional.

sábado, 19 de septiembre de 2009

Formación de la Imagen

lunes, 14 de septiembre de 2009

Fundamentos de fotografía

Cuando hablo de técnica fotográfica me refiero a cuestiones tales como comprender que si uso un objetivo de longitud focal grande obtendré una menor profundidad de campo que si la longitud focal es más pequeña. Que cuando se realiza fotografía de aproximación la dificultad de enfocar se vuelve muy alta y normalmente deberé utilizar enfoque manual porque el autoenfoque no se comporta correctamente.

El conocimiento de estas cuestiones nos permitirá abordar cada toma con el suficiente bagaje como para que los resultados obtenidos sean mímimamente satisfactorios. Pero, a veces, nos plantearemos el porqué de estas afirmaciones.

En otras ocasiones se trata simplemente de entender misterios tales como que el flamante objetivo 18-200 que acabamos de adquirir mide bastante menos de los 20 cmm que aparentemente debería medir.

Es decir, se trata de entender porqué las cosas son como son y no simplemente interiorizar reglas de comportamiento.

Es discutible que este conocimiento nos permita obtener mejores fotografías, pero lo que es casi seguro es que nos permitirá evitar algunos errores. Por otro lado, todos los fotográfos entusiastas conocen tanto el qué como el por qué y nuestro desconocimiento nos conducirá inevitablemente a estar en inferioridad de condiciones.

Por todos estos motivos he decidido inaugurar una sección en el blog dedicada a entender con mayor profundidad los fundamentos de la fotografía. Los artículos aparecerán precisamente bajo la etiqueta fundamentos. Como la dificultad de lectura es, en muchos casos, mayor que la de otros temas que aparecen en el Blog, procuraré alternalos con otros de naturaleza más comprensible.

martes, 8 de septiembre de 2009

El color en la fotografía

Hay dos posibles respuestas:

a) El color es la longitud de onda de una onda electromagnética siempre y cuando su valor se encuentre entre 400 y 700 nanómetros, más o menos. Si la longitud de onda es menor hablaremos de rayos ultravioleta, rayos x o rayos gamma. Si es mayor hablaremos de rayos infrarrojos, microondas, etc. !Eso es todo, amigos¡.

Es decir, es algo de naturaleza puramente matemática. . La pregunta es: ¿Existe en la naturaleza algo que posea un color determinado, o lo que es lo mismo, una longitud de onda determinada?. En realidad ciertas transiciones electrónicas entre las capas de mayor y menor energía de un átomo producen radiaciones electromagnéticas en las que la longitud de onda es un valor real con muchos números decimales. Por ejemplo el sodio emite una luz amarilla a una longitud de onda muy concreta. Ésto en cuanto a la luz emitida. La luz reflejada nunca tiene una longitud de onda concreta, sino que está formada por una mezcla de longitudes de onda más o menos próximas.

b) El color es lo que subjetivamente interpreta nuestro cerebro a partir de la información enviada por unas células sensibles a este rango de longitudes de onda que poseemos en nuestro sistema visual.

¿Para ésto necesito diagramas?

Incrementemos nuestro vocabulario. Cuando comenzamos a estudiar la teoría del color en fotografía, antes o después nos encontraremos con lo siguientes términos:

1) Tono (hue, en inglés).

Este término es un sinónimo de la longitud de onda a la que antes hacíamos referencia. La única diferencia es cuando hablamos de longitud de onda diremos que ésta de de 525 nanómetros y cuando hablamos de tono diremos que es "verde". Signifique ésto lo que quiera significar.

2) Brillo o Luminosidad (brightness, en inglés).

Este término no está relacionado con la cualidad de la luz, sino con su cantidad. Es decir, si estamos en un parque a mediodía y miramos una hoja, la veremos verde brillante. Si estamos en el mismo parque cuando esté oscurenciendo la veremos verde oscuro. No hay más.

Dado que la fotografía se dedica a captar la luz reflejada por los objetos y rara vez la luz emitida (por ejemplo rayos o fuegos artificiales) el brillo dependerá tanto de la fuente de luz que ilumine el objeto como del índice de reflexión del propio objeto. Cuando nos centramos en el ámbito de la fotografía digital, la luminosidad adquiere un significado ligeramente distinto que tiene como protagonista al sensor. Pero esto se explica mejor en el ámbito de los modelos de color. Será el próximo artículo sobre el tema.

3) Saturación (saturation, en inglés).

Este término nos indica la pureza del tono. Me explico. Si la onda electromagnética fuera de una longitud de onda concreta -o, en casos reales de la naturaleza- formada por una mezcla de diferentes longitudes de onda, pero dentro de un intervalo muy estrecho, diremos que la luz está saturada.

Si, en cambio, la luz está formada por contribuciones de una gran parte de las longitudes de onda del espectro visible, diremos que es luz blanca. Esta luz es muy poco saturada. De hecho no hay una única luz blanca, sino diferentes posibilidades dependientes de cuáles sean las diferentes longitudes de onda que contribuyan a su formación. Este es el concepto subyacente al denominado balance de blancos. Si en lugar de hablar de luz emitida hablamos de luz reflejada la poca saturación se traduce en tonos grises. El término gris neutro, de frecuente uso en fotografía, será explicado con posterioridad.

miércoles, 2 de septiembre de 2009

Controles de objetivo

Aunque no todos los objetivos tienen el mismo número de controles, los que con mayor frecuencia podemos encontrarson los siguientes:

a) Anillo de enfoque.

Todos los objetivos disponen de un anillo de enfoque para poder realizar un enfoque manual. Lo que también es cierto es que desde el momento en que los sistemas de autoenfoque se han vuelto ubicuos, las oportunidades de utilización de este control han quedado en la práctica reservadas a un cierto número de casos especiales donde su utilidad es imprescindible. Recomiendo revisar el artículo sobre enfoque manual que aparece en el Blog.

La superficie y posición -más próximo al frontal del objetivo o más próximo a la montura- pueden ser diferentes entre difierentes fabricantes y, en ocasiones, dentro de las diferentes series de un mismo fabricante.

Este es el único control presente en absolutamente todos los objetivos.

b) Anillo de zoom.

Es un control que, como es lógico, sólo aparece en aquellos objetivos que son zoom y nunca en aquellos que son de longitud focal fija. Su misiónes permitir modificar la longitud focal del objetivo. Al igual que en el caso del anillo de enfoque su posición y tamaño puden variar entre diferentes objetivos.

c) Anillo de diafragmas.

Este control nos permite modificar la apertura del diafragma del objetivo. Su presencia era casi total en los objetivos destinados a cuerpos de cámara de película. En los últimos años, por otro lado, prácticamente ninguno de los objetivo diseñados específicamente para réflex digitales lo posee. La explicación es que en la actualidad la variación de la apertura del diafragma se realiza desde un control situado en el el propio cuerpode la cámara.

Asociado a este control existe habitualmente una escala de números f que permite determinar de forma aproximada la profundidad de campo. Esta función ha sido asumida en la actualidad por un control del cuerpo de la cámara que nos permite "previsualizar" esa profundidad de campo.

d) Conmutador de autoenfoque a enfoque manual.

Este mecanismo, que se puede encontrar implementado bien como propiamente un conmutador o bien de alguna otra forma, caso por ejemplo del Tamron Macro 90 mm. f2.8, nos permite realizar el enfoque o bien manualmente -mediante el anillo de enfoque- o bien automáticamente, mediante el autoenfoque.

Existen dos circunstancias que condicionan de alguna manera su utilización. En primer lugar la existencia de un conmutador similar en el propio cuerpo de la cámara. En este caso es necesario que haya una adecuada coordinación entre ambos. Es decir que si tenemos el conmutador del cuerpo en posición manual, no pretendamos que funcione el autoenfoque del objetivo.

En segundo lugar, y matizando lo anterior, existen objetivos en el mercado que aún estando tanto el conmutador de la cámara como el del propio objetivo en posición de autoenfoque, permiten el enfoque manual. Su comportamiento es tal que cuando sienten la rotación del anillo de enfoque manual desactivan el autoenfoque. Es muy importante estar seguros de disponer de un objetivo con esta cualidad si realizamos este tipo de operación. En caso contrario corremos el riesgo de dañar irreversiblemente el motor de autoenfoque.

e) Conmutador de estabilización.

Algunos objetivos disponen de uns sitema giroscópico electrónico que detecta el movimiento del objetivo cuando disparamos a pulso y lo compensa adecuadamente para evitar el desastroso efecto de trepidación en las fotos. En los casos más evolucionados nos permiten disparar hasta 4 pasos por debajo en la velocidad de obturación. Estos objetivos tienen la particularidad de que suelen ser bastante más caros que aquellos que no llevan incorporada esta funcionalidad. Conviene aclarar que en la actualidad existe una forma alternativa de procurar estabilización que se concreta en el movimiento del sensor y que por tanto se ubica en el interior de la cámara. En estas condiciones todos los objetivos quedan estabilizados. También es pertinente añadir que las dos marcas punteras en fotografía, Canon y Nikon, utilizan objetivos estabilizados.

En algún caso el conmutador de estabilización posee dos posiciones en lugar de una. Se trata de una estabilización normal para fotos tomadas a pulso, como antes comentábamos y una estabilización especial que se utiliza cuando disparamos desde un vehículo en movimiento y por tanto mucho más agresiva.

Un último punto a tomar en consideración es la necesidad de desactivar esta funcionalidad -me refiero a la estabilización normal, la otro queda limitada a ese caso especial- cuando utilizamos un trípode. Si no lo hacemos así el mecanismo de estabilización puede jugar en nuestra contra y obtener un resultado menos nítido de lo esperado.

f) Limitador de enfoque.

Algunos objetivos, fundamentalmente macros, tienen un mecanismo que nos permite limitar el rango de distancia en que opera el autoenfoque. Básicamente disponemos de dos posiciones que permitirán al mecanismo de autoenfoque actuar en distancias muy próximas, cuando deseemos aprovechar su característica macro, o bien en distancias normales.

Por último, aunque no es en realidad un control, quería comentar el hecho de que algunos objetivos llevan en su interior el propio motor de autoenfoque y otros no. En teoría estos objetivos funcionan con mayor precisión y seguridad. Si un cuerpo de cámara se monta con uno de estos objetivos la información que se establece a través de los contactos de la montura hace funcionar el motor de enfoque del propio objetivo. Si, en cambio el objetivo no dispone de motor de enfoque es el motor de enfoque del cuerpo de la cámara el que actúa através de una pequeña pestaña en la parte posterior del objetivo. Para acabar de complicar las cosas, en la actualidad algunos cuerpos de cámaras réflex digitales -las más baratas de las marcas punteras- carecen de motor de enfoque. En esas condiciones o bien el objetivo posee por sí mismo motor de enfoque o sencillamente sólo podremos utilizar el enfoque manual.

jueves, 27 de agosto de 2009

Flash de sincronización lenta

La solución es utilizar el modo de sincronización lenta del flash. En esta modalidad el comportamiento de la luz del flash y la exposición que otendremos con ella será la habitual, pero a diferencia del caso estándar tendremos la posibilidad de determinar la velocidad de obturación para el resto de la escena. Como ésta puede llegar en muchos casos a los 30 seg. no habrá dificultad en que sea la adecuada.

Una complicación adicional que se nos puede presentar cuando fotografiamos personas es la tendencia que éstas tienen a moverse tras detectar el destello del flash. Cuando utilizamos esta modalidad de sincronización debemos advertir a la persona que se esté muy quieta pues cualquier movimiento posterior quedará reflejado en la fotografía final. Una necesidad obvia en estos casos, por extraña que parezca, es la de utilizar trípode.

Un detalle a tener en cuenta es que dependiendo del cuerpo de cámara o del propio flash quizás no podamos utilizar todos los métodos de medición de la exposición posibles. Quizás nos veamos obligados a utilizar prioridad al obturador o bien prioridad a la apertura o alguna otra combinación.

Resumiendo, es como si se tomara una fotografía con dos exposiciones. La del sujeto principal se gestiona a través del flash, con sus propias característicasy la del resto de la escena -el fondo- se gestiona de la manera habitual, con trípode y bajas velocidades de obturación. Eso sí, siempre que el contexto general sea de iluminación de baja intensidad. Si ésto no fuera así entrarían en juego otros matices que ya comentaremos en su momento.

viernes, 21 de agosto de 2009

Longitud focal equivalente

Para poder entender lo que significa debemos primero recordar algunos detalles. En el panorama actual de cámaras fotográficas, si nos olvidamos de cámaras de formato medio y respaldos digitales de uso exclusivamente profesional, existen tres tipos de tamaños de sensores involucrados:

a) Sensores de formato completo de 24x36 mm con un tamaño similar al de un fotograma de película.

b) Sensores de tamaño APS-C de tamaño algo menor. Por cierto esta denominación surje de un tipo de fotograma de película que apareció uno pocos años antes del advenimiento de la era digital y que pretendía normalizar el uso de los carretes con un formato más seguro y que proporcionara más información al cuerpo de la cámara de lo que lo hacían los carretes convencionales.

c) Sensores de compactas de un tamaño mucho más reducido.

¿Y qué tiene que ver el tamaño del sensor con el factor de recorte?. Mucho.

La longitud focal de un objetivo - o una determinada posición de longitud focal en un zoom - tiene dos efectos importantes. Por un lado nos da un ángulo de visión de la escena. Es bien conocido que un objetivo de poca longitud focal, un angular, nos ofrecerá una más amplia visión de la escena que uno de mayor longitud focal, los conocidos como teleobjetivos.Por otro lado influye en la profundidad de campo. Un objetivo de menor longitud focal tendrá una mayor profundidad de campo que un teleobjetivo. Eso sí considerando fijos el resto de factores que influyen: la distancia al sujeto y laapertura elegida.

Ahora bien, la longitud focal de un objetivo, que es una medida absoluta, hará que éste se comporte diferentemente cuando lo colocamos en cuerpos de cámaras con diferentes tamaños de sensor. Así, por ejemplo, un objetivo de 50 mm colocado en una cámara con sensor de formato completo se comportará como un objetivo "normal", es decir, aquél cuyo ángulo de visión se corresponnde más o menos con el que tiene el ojo humano. Si lo colocamos en una cámara con sensor de formato APS-C se comportará como un teleobjetivo corto. Por eso decimos que el objetivo tiene un factor de recorte , lo cual significa que su ángulo de visión será menor si lo colocamos en una cámara con sensor de formato APS-C que si lo colocamos en una cámara con un sensor de formato completo. Debido a que el sensor APS-C es menor subtiende un ángulo menor.

Esta peculiaridad tiene mucha influencia en los extremos de longitudes focales. Así si colocamos un objetivo de 200 mm en una cámara de formato APS-C se comportará como si colocáramos un objetivo de 300 mm en una cámara con sensor de formato completo. Y resulta que un objetivo de 300 mm es mucho más caro que uno de 200.De igual manera, pero ahora como una inconveniencia, si colocamos un objetivo de 28 mm, que se comportaba como un angular en un cuerpo con sensor de formato completo, se comportará casi como un objetivo normal si lo colocamos en una cámara con sensor de tamaño APS-C. Y resulta que los objetivos de longitud focal muy pequeña son más caros. Es decir, que lo que ganamos en un extremo lo perdemos en el otro.

Por tanto el factor de recorte se refiere básicamente al cambio de ángulo de visión que obtenemos cuando colocamos un objetivo de una cierta longitud focal primero en una cámara con formato APS-C - o un compacta- y luego (si ello fuera posible) en una cámara con formato completo. Ésta comparación se hace de esta manera y no de otra porque durante la mayor parte de la historia de la fotografía el formato de fotograma de 24x36 mm es el que ha dominado la escena. O lo que es lo mismo si colocamos un objetivo de 50 mm en una cámara con sensor de formato APS-C tendrá una longitud focal equivalente - es decir, un ángulo de visión equivalente- al que tendríamos si colocáramos un objetivo de 75 mm en una cámara con sensor de formato completo. Esto se suele expresar afirmando que la longitud equivalente es 1.5X.

Un último aspecto a considerar es que las profundidades de campo conseguidas están relacionadas con la longitud focal real del objetivo y no con la longitud focal equivalente. Por tanto en el ejemplo anterior aún cuando colocando el objetivo de 50 mm en una cámara de formato completo obtengamos el mismo ángulo de visión que si colocáramos un objetivo de 75 mm en una cámara con sensor de formato completo, la profundidad de campo sería la correspondiente a un objetivo de 50mm, mayor que la del objetivo de 75mm.

Este es el motivo por el cual es tan difícil obtener desenfoques selectivos en las compactas. Dado que las longitudes focales de lo objetivos involucrados son tan pequeñas en términos absolutos sus profundidades de campo son siempre muy altas. Es posible que una longitud de 5 mm tenga el mismo ángulo de visión que un objetivo de 50 mm en una cámara con sensor de formato completo, pero su profundidad de campo será siempre altísima.

sábado, 8 de agosto de 2009

Sitios de fotografía

Con respecto a la conveniencia de utilizar este tipo de sitios para exponer nuestro trabajo -siempre en un contexto de aficionado, nunca el de profesional- encuentro tres graves inconvenientes que paso a detallar:

a) El principal, desde mi punto de vista, es el efecto avalancha. A estos sitios se suben continuamente fotografías. Muchas personas se limitan a contemplar las novedades y nuestra fotografía puede ser una novedad durante minutos o incluso segundos. A partir de ese momento seremos invisibles. Bien es cierto que en muchos casos podemos utilizar un enlace y enviarlo por correo electrónico o insertarlo en alguna otra página Web, pero el tema fundamental es que nuestra fotografía frecuentemente quedará sepultada entre cientos o miles de otras y será difícil volver a localizarla.

b) Un tema interesante es el de las limitaciones. Las hay de tamaño, resolución e incluso temática. Estamos pues sometidos a la arbitrariedad de quien mantiene administrativamente el sitio. Estas limitaciones a veces son fundamentales para conseguir algún orden en el caos pero, desde nuestro punto de vista como fotógrafos aficionados, se traducen en una merma de libertad.

c) La tercera razón apunta a una sensación de "colegueo" que se observa en algunos de estos sitios. A menudo se alaban indiscriminadamente fotografías sólo correctas y se ignoran olímpicamente algunas otras que tienen una mayor calidad. Tangencialmente relacionado con este aspecto destaca la presencia en estos sitios de algunos individuos que en el mejor de los casos podríamos catalogar como "frikis". Un caso que recuerdo especialmente, en uno de los foros de este tipo de sitios, es del uno de estos "frikis" afirmando que se "iba a pillar" una Canon 1Ds Mark II a la mayor brevedad. Es evidente que quien se expresa con tan bajo nivel cultural es muy difícil que tenga los conocimientos técnicos y/o el suficiente nivel económico para poder manejar una cámara de esas características.

Es posible que alguien que haya visitado este sitio y haya navegado a su página principal piense que estoy cayendo en una enorme contradicción pues desde allí es posible acceder a una galería de fotografías almacenada en Albunes Web de Picassa. La explicación es que mi intención no es que esas fotografías estén accesibles a través de la propia búsqueda en la aplicación de Google, sino siguiendo precisamente el enlance desde la página principal.En esas condiciones podrán ser siempre localizadas con total garantía.

jueves, 30 de julio de 2009

Aberraciones cromáticas

La aberración cromática es un efecto óptico que se produce debido a que la luz que atraviesa el objetivo, al refractarse - cambiar de dirección- lo hace con diversos ángulos que dependen de su longitud de onda. Debido a esta circunstancia no todos los rayos luminosos convergen en el plano focal. Algunos lo hacen un poco más allá y otros un poco más acá. Esto es conocido como aberración cromática longitudinal (Existe otro tipo denominada lateral).

La aberración cromática es un efecto óptico que se produce debido a que la luz que atraviesa el objetivo, al refractarse - cambiar de dirección- lo hace con diversos ángulos que dependen de su longitud de onda. Debido a esta circunstancia no todos los rayos luminosos convergen en el plano focal. Algunos lo hacen un poco más allá y otros un poco más acá. Esto es conocido como aberración cromática longitudinal (Existe otro tipo denominada lateral).Desde el punto de vista práctico, lo que se observa es la presencia de uno halos de color púrpura, cyan, azul o rojo alrededor de ciertos sujetos del encuadre.No todos los objetivos presentan el mismo nivel de aberración cromática, porque los más costosos utilizan técnicas de corrección que minimizan el problema. De todas maneras es necesario insistir en los siguientes puntos:

a) Este efecto suele manifestarse con claridad cuando observamos la fotografía a su resolución real y no es a veces observable cuando utilizamos un porcentaje bajo de pixeles en su visualización. Lo cual quiere decir que es importante observar siempre las fotografías a resolución real.

b) Se manifiesta especialmente cuando existe una transición brusca de luminosidades entre superficies relativamente uniformes. Por ejemplo, si observamos un edificio contra un cielo azul limpio, es muy probable que se presente este problema.

c) Afecta más a objetivos angulares.

d) Afecta más a grandes aperturas (Números f bajos).

En ambos casos la explicación es que los rayos presentan unos ángulos de penetración más inclinados con respecto a la normal del objetivo. El problema es que normalmente para una fotografía concreta no estamos en disposición de cambiar estos parámetros.

La buena noticia es que los editores fotográficos permiten eliminar casi totalmente la aberración cromática sobre todo si utilizamos formatos de fichero raw.

Resumiendo:- Si disparas con una compacta y vas a imprimir en 10x15, tendrás abundante aberración cromática, pero no la verás.- Si eres aficionado a la fotografía, sigue estos consejos:

1) Cómprate objetivos de calidad.

2) Aprende a reconocer las situaciones que potencialmente pueden dar lugar a este problema

3) Intenta, si es posible no utilizar aperturas muy amplias en estas circunstancias.

4) Utiliza el formato raw.

5) Aprende a utilizar algún editor gráfico (sí, ése que todos conocemos) que te permite eliminar razonablemente este problema.

viernes, 24 de julio de 2009

Tarjetas de memoria

Debido a la diversidad de marcas y mecanismos de rotulación de sus características a veces es difícil entender las diferencias que existen entre unas y otras, provocando en el aficionado mucha incertidumbre a la hora de su elección. Aunque existen muchas características importantes que diferencian unas tarjetas de otras las que más nos pueden interesar son realmente dos:

a) Capacidad

b) Velocidad de transferencia

Con respecto a la capacidad poco hay que decir pues siempre queda claro cuál es ésta. No obstante en lo que respecta a las tarjetas SD hay que conocer que existen dos diferentes especificaciones. Por una lado la que denominaríamos SD clásica con capacidades hasta 4GB y la más novedosa SDHC (Secure Digital High Capacity) con capacidades desde 4GB hasta 32 GB. Se ha anunciado una nueva especificación denominada SDXC (Secure Digital Extended Capacity) con capacidades desde 32 GB hasta 2Tb, pero actualmente no tiene presencia comercial.

Con respecto a la velocidad de transferencia las cosas se complican un poco más.En primer lugar hay que conocer que las velocidades se miden en múltiplos de 150 Kb/seg (1X). Las tarjetas SDHC se han dividido en tres clases: Clase 2 , Clase 4 y Clase 6 con las siguientes velocidades de tranferencia mínimnas

Clase 2: 2Mb/seg (13X)

Clase 4: 4Mb/seg (26X)

Clase 6: 6Mb/seg (40X)

Ahora bien nada impide que una tarjeta de clase 6 tenga por ejemplo una velocidad de transferencia de 45 Mb/seg (300X)

En cuanto a las tarjetas CF la velocidad se expresa o bien en Mb/seg o bien en valores X.

Para las velocidades más populares en este momento, una tabla de equivalencia sería la siguiente:

133X 20 Mb/seg

150X 22,5 Mb/seg

200X 30 Mb/seg

266X 40 Mb/seg

300X 45 Mb/seg

sábado, 18 de julio de 2009

El Flash. Sincronización a la segunda cortina

En la configuración por defecto del flash, el fogonazo de luz se produce justo cuando la primera cortina ha dejado descubierto el sensor. Cuando utilizamos la sincronización a la segunda cortina el fogonazo se produce inmediatamente antes de que ésta comienze a moverse.

Una circunstancia común en ambas situaciones es que el sensor se encuentra completamente expuesto. Debemos recordar que si se permitiese que el flash entrase en acción antes de la que la primera cortina hubiera despejado el sensor o bien cuando la segunda cortina ya hubiera iniciado su movimientonos, encontraríamos que únicamente una ranura - de mayor o menor extensión- pero no la superficie completa del sensor estaría expuesta a la luz del flash.

¿Qué implicaciones prácticas tiene ésto?. En la inmensa mayoría de las ocasiones ninguna. Ahora bien, existen casos en los que una fuente de luz secundaria se mueve dentro del encuadre en los cuales sí podemos notar que existen diferencias. El caso más simple para poder entederlo es cuando un coche con los faros encendidos se está moviendo y decidimos hacerle una fotografía.

Si utilizamos la sincronización a la primera cortina, el fogonazo del flah -por supuesto de número de guía suficiente para este menester- registra en el sensor su imagen. Posteriomente en el tiempo que pasa hasta que la segunda cortina cierra el acceso de la luz al sensor las luces del vehículo impresionan un rastro que surje antinaturalmente por delante del vehículo. El resto de la imagen del vehículo permanece invisible poque la exposición es insuficiente para registrarla.

Si, en cambio, utilizamos la sincronización a la segunda cortina las cosas suceden de un modo ligeramente diferente. Primero se observa el trazo de luz de los faros y posteriomente, en el momento del fogonazo del flash se registra el vehículo. En este caso, en la imagen definitiva nos encontraremos con que a partir de los faros y hacia atrás queda registrada su traza . Es una situación mucho más natural.

martes, 23 de junio de 2009

Números f

Cuando se intenta explicar el concepto de exposición se suele recurrir a una analogía en la que un recipiente -cuyo tamaño representa el valor ISO- se llena con agua proveniente de un grifo. El grifo proporciona una corriente de agua de menor o mayor grosor - la apertura- durante un cierto tiempo - la velocidad de obturación - de tal manera que vamos a ser capaces de llenarlo tanto con un chorro grueso durante un corto período de tiempo como con un chorro fino durante un tiempo mayor.

A partir de este momento, la comprensión de la escala de velocidades de obturación 8, 4, 2, 1,1/2, 1/4, 1/8, 1/16 y así sucesivamente no presenta ningún problema: Es fácilmente entendible que si tenemos el obuturador abierto 1/2 seg entrará por el objetivo el doble de luz que si lo tenemos abierto 1/4 seg.

Otra cuestión bien distinta es entender el signifcado de los números f. La secuencia habitual es la siguiente: 1, 1.4, 2, 2.8, 4, 5.6, 8, 11, 16, 22. ¿Qué diablos significa ésto?. Es evidente que está relacionado con el área del círculo que generan las laminillas del diafragma. (Recordemos la analogía del grifo). ¿Pero, cómo?.

Para entender la respuesta debemos fijarnos en la figura simplificada que aparece al comienzo, en la cual la distancia del objetivo al sensor representa la longitud focal del objetivo.

Es evidente que un objetivo de mayor longitud focal deberá tener una apertura mayor para proporcionar la misma luz que uno de menor longitud focal.

En primer lugar, el número f se define como el cociente entre el diámetro del círculo formado por las laminillas del diafragma y el valor de la longitud focal, ambos expresandos en milímetros.

Es decir Numero f = Longitud Focal / Diámetro

Lo que ocurre es que seguimos sin intender qué significan esos números. Y sobre todo por qué no es un continuo de valores sino que más bien parece que haya algunos privilegiados. Un primer paso que aclara el tema es el hecho de que el significado de cada número f en la secuencia anterior es que la apertura del diafragma en esa posición deja pasarla mitad de luz que en la posición anterior, más abierta. Es decir que una apertura de f5.6 deja pasar el doble de luz que una apertura de f8 y la mitad que una de f4.

Es obvio que de alguna manera estos números están relacionados con el área del círculo correpondiente a esa apertura. Para probarlo, supongamos que tenemos dos cículos A y B y que deseamos que A tenga el doble de área que B.

¿Cuál debería ser la relación entre sus radios ra y rb?

Recordemos que AreaA = PI . ra. ra y que Areab = PI. rb . rb

Si afirmamos que AreaA = 2 Areab, nos encontraremos que PI. ra. ra = 2. PI. rb. rb o bien que

ra = (Raiz de 2). rb y definitivamente que ra / rb = 1.41

Por tanto, para que un círculo tenga el doble de área que otro menor, debe tener un radio que sea el producto de 1.4 por el radio del círculo pequeño. Existe una fórmula análoga que relaciona a los correpondientes diámetros: da/db = 1.41

Dado que estamos interesados en los valores relativos de los sucesivos diámetros y no en sus valores absolutos, tomemos como valor unidad el correpondiente al diámetro de la apertura que coincide con la longitud focal, es decir lo que denominamos apertura f1. Llamémoslo da; llamemos db, dc, de, de, etc a los sucesivos diámetros que hacen que en cada caso la cantidad de luz disminuya a la mitad.

f1 da = 1

f1.4 da/db = 1.4

f2 da/dc = (da/db) . (db/dc) = 1.4 . 1.4 = 2

f2.8 da/dd = (da/dc) . (dc/dd) = 2 . 1.4 = 2.8

f4 da/de = (da/dd) . (dd/de) = 2.8 . 1.4 = 4

y así sucesivamente (Si se hacen las cuentas con calculadora salen números con decimales que se redondean a los expuestos).

Es evidente que otra forma ligeramente distinta de ver los números f sería como el cociente entre el diámetro de la apertura del diafragma que coincide con la longitud focal y el diámetro correpondiente a los círculos que dejan pasar 1/2, 1/4, 1/8 de luz y así sucesivamente.

Conviene señalar que para objetivos reales es muy poco frecuente - pero que muy poco- que haya objetivos que consigan llegar al valor de f1 como apertura máxima.

Por último, el uso de los números f nos permite una simplificación del concepto de apertura porque, si no existieran, deberíamos hablar de un área para una cierta longitud focal. Es decir manipular dos valores distintos. En cambio al utilizar los números f estamos manipulando un único valor.

jueves, 18 de junio de 2009

Modos de disparo

a) Disparo único

Sucede lo que acabamos de comentar y obtenemos una única fotografía. Es el modo usual de utilización de la cámara. Es el modo por defecto en aquellas cámaras en las que la elección se hace a través de menú y, en general, el que se utiliza con mayor frecuencia.

b) Disparo continuo

En este caso tras pulsar el disparador hasta el fondo la máquina realiza una serie de fotografías consecutivas a una cierta velocidad hasta que se llena el buffer. En fotografía profesional es de una enorme importancia, pues al hacer muchas tomas seguidas es más fácil que alguna de ellas sea la que se espera obtener, sobre todo si se utiliza en entornos donde no es posible realizar una preparación concienzuda de la toma. Esto suele suceder eneventos deportivos, fotografías de reuniones sociales, etc. Cierto cuerpos de cámara inciden en este aspecto y destacan especialemente por su enorme frecuencia de disparo y el tamaño de su buffer. En general no son adecuados para los aficionados, pues éstos realizan un tipo de fotografía más diversa. Un caso especial de disparo continuo se utiliza en el contexto del uso del horquillado. La diferencia fundamental estriba en que aquí el número de disparos está predeterminado.

c) Autoretrato

Es simplemente un disparo único retardado mediante un temporizador. Es decir que tras pulsar a fondo el disparador existe un lapso de tiempo de algunos segundos hasta que se levanta el espejo y se mueve la cortina del obturador. Su denominación hace referencia al hecho de que su mayor utilidad es precisamente en el ámbito de los autoretratos. En esta situación el fotógrafo se ubica en el campo de visión del objetivo y se convierte en sujeto de la fotografía.

d) Levantamiento de espejo

Este es un método especializado que se utiliza con mayor frecuencia en combinación con el uso de objetivos de una gran longitud foca o bien en fotografía macro. Normalmente exige la utilización de un disparador remoto. Su necesidad surge por el hecho de que la más mínima vibración pueda comprometer la nitidez de la toma. Su modo de operación consiste en que al pulsar el disparador a fondo se levanta inmediatamente el espejo. Posteriormente o bien con un mecanismo de retardo o bien con una nueva pulsación del disparador se retira la cortina del obturador y se realiza la toma. La referencia a la necesidad de eliminar vibraciones se refiere al hecho de que el levantamiento del espejo -un elemento mecánico- realizada inmediatamente antes del movimiento de la cortina es capaz de producir esas vibraciones. Si dejamos pasar un poco de tiempo éstas se amortiguan hasta hacerse inapreciables.